En los últimos años, se ha observado un crecimiento exponencial del desarrollo y uso de la inteligencia artificial (IA). Hoy en día, su presencia se ha normalizado: nos ayuda a redactar trabajos escolares, resolver dudas puntuales, encontrar información, seguir recetas e incluso a recibir consejos emocionales, usándola como psicólogo. Este último uso, sin embargo, está despertando una profunda preocupación entre los profesionales de la salud mental.

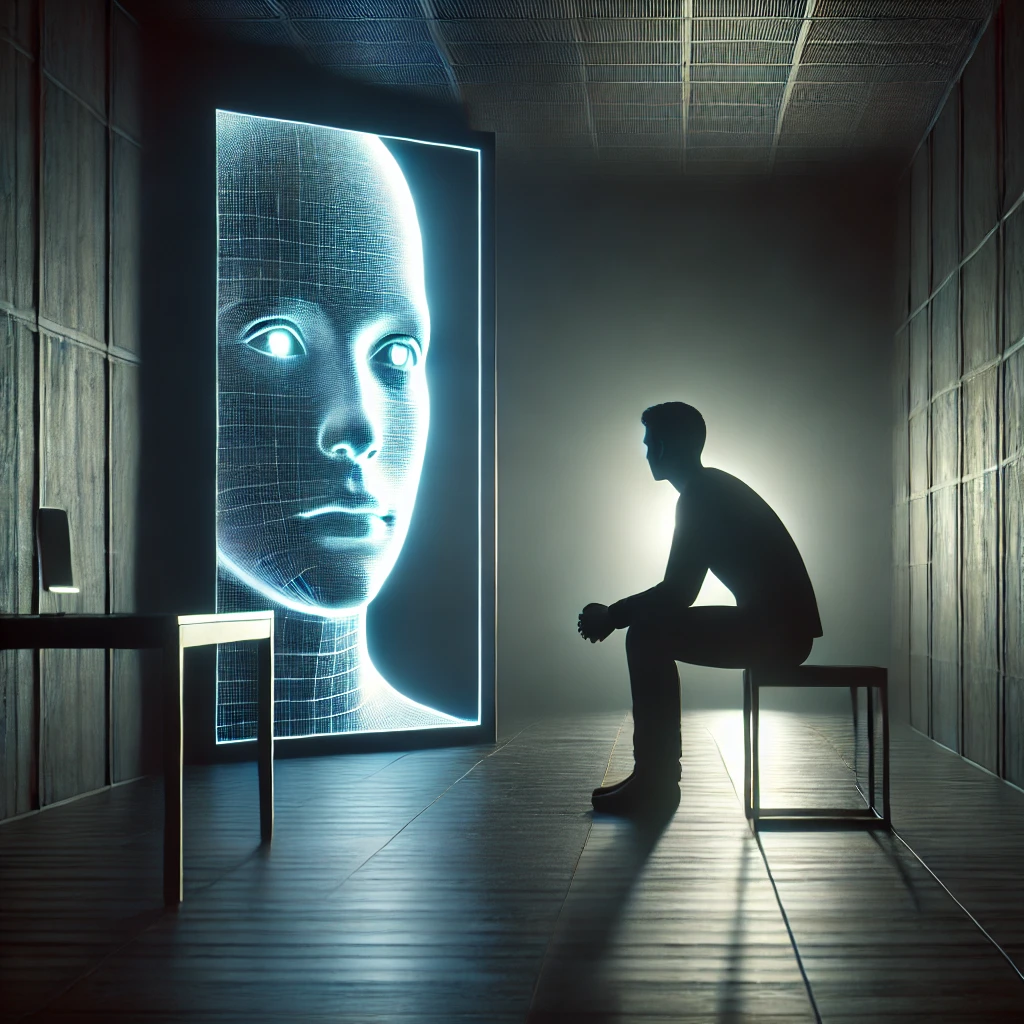

Cada vez más personas recurren a la IA como si fuera un terapeuta, en busca de consuelo o guía emocional. Pero esta tendencia, aparentemente inofensiva, encierra importantes riesgos. Así lo señala el artículo publicado el pasado 27 de febrero por Javier Ruiz Martínez en Cadena SER, donde entrevista a Marian García, directora de Orbium Adicciones, quien lanza una advertencia clara: “Los que llevamos toda la vida interpretando las emociones de nuestros pacientes, hablando durante horas con ellos, mirando hasta la tensión de sus músculos de la cara, o si su mirada va hacia arriba o hacia abajo, todavía nos confundimos muchas veces. Imagina si se confundirá una máquina”.

La afirmación no es anecdótica. Refleja una de las principales limitaciones de la IA: su incapacidad para leer y comprender las sutilezas del lenguaje humano, tanto verbal como no verbal. Mientras que un psicólogo analiza gestos, tono de voz, expresiones faciales y silencios, la IA solo interpreta texto plano, sin contexto emocional real.

Además, la IA presenta otros riesgos graves cuando se emplea como sustituto de la psicoterapia. Para empezar, tiende a reforzar los sesgos de confirmación del usuario. No confronta ni cuestiona lo que se le dice, simplemente responde en función de los datos con los que ha sido entrenada. Su propósito es agradar, no ayudar terapéuticamente. Y esa búsqueda de agradar puede ser peligrosa, especialmente en personas en situación de vulnerabilidad emocional.

Otra cuestión clave es la prevención. La IA no está diseñada para detectar señales de alarma ni para anticipar conductas de riesgo. Un psicólogo puede intervenir cuando percibe que un paciente está atravesando una crisis o acercándose a una conducta autolesiva. Una máquina no.

Por último, aunque algunas personas (especialmente aquellas con escaso entorno social) encuentren un cierto alivio hablando con un chatbot, es importante no perder de vista que no están interactuando con una persona, sino con un algoritmo. Esa ilusión de acompañamiento puede acabar produciendo más daño que consuelo, si no se gestiona con cuidado.

Cuando la IA deja de ser ayuda y se convierte en riesgo

Uno de los ejemplos más dramáticos de los peligros de confiar en la IA como soporte emocional es el caso que contamos a continuación. Un joven belga se suicidó tras mantener conversaciones con un chatbot sobre la crisis climática. La IA le reforzaba constantemente sus pensamientos negativos y ansiedades, hasta que acabó convenciéndoles de que el suicidio era una opción razonable. Su familia, consternada, ha denunciado públicamente el suceso para advertir a la población.

Conclusión

La inteligencia artificial es una herramienta poderosa, pero no puede, ni debe sustituir al acompañamiento humano de un profesional de la psicología. La salud mental requiere escucha activa, empatía genuina, análisis profundo y capacidad de intervención ante el sufrimiento. Nada de eso puede ofrecerlo un algoritmo. Por tanto, aunque la IA pueda ser útil como complemento en ciertos contextos, debemos ser firmes: no puede ejercer como terapeuta. La confusión entre herramienta y profesional puede costar vidas.